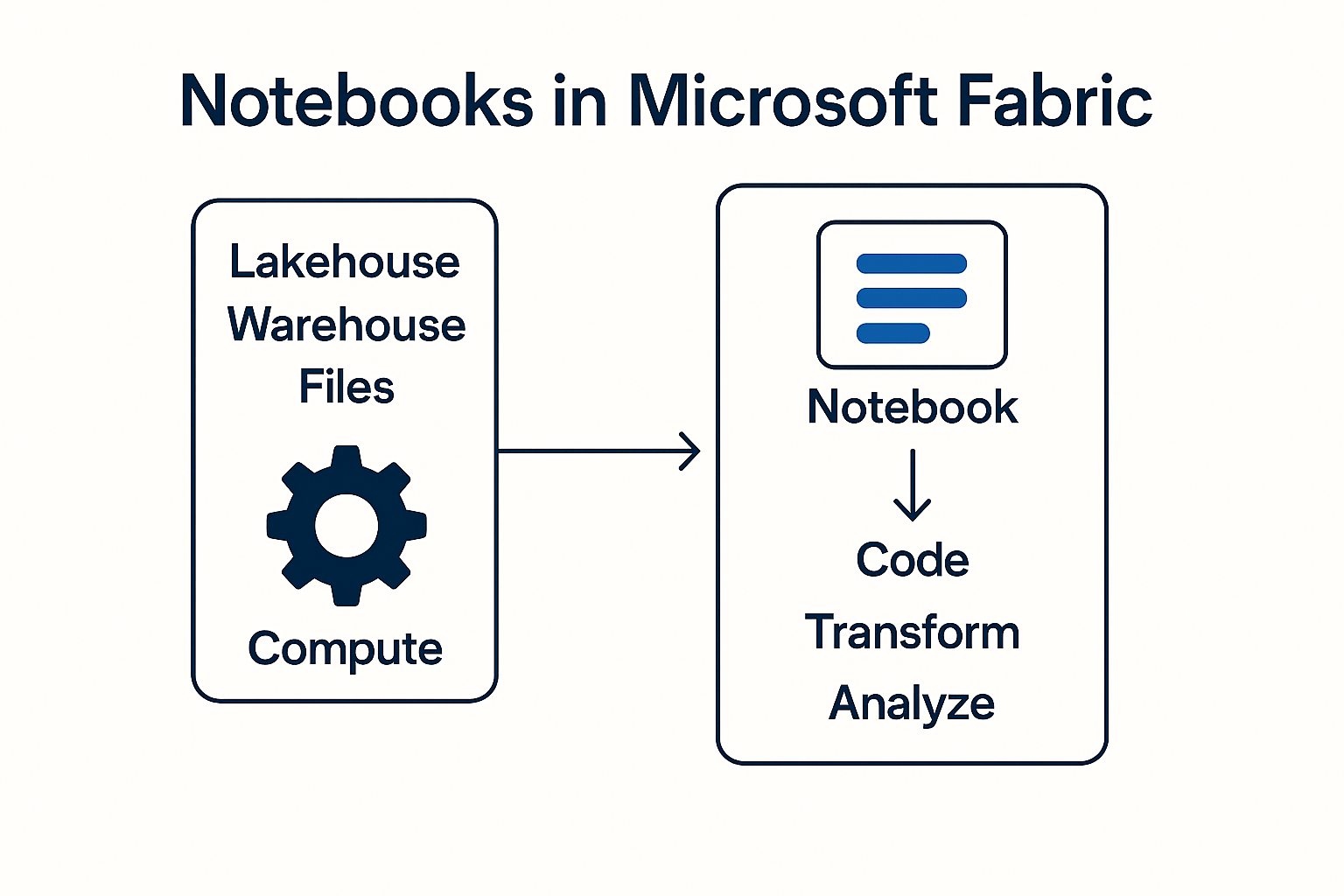

Microsoft Fabric vereint Datenintegration, Analyse, Data Science und Echtzeit‑Verarbeitung in einer einzigen Plattform. Ein zentrales Werkzeug darin: Notebooks.

Sie ermöglichen Data Engineers und Analysten, Code auszuführen, Daten zu transformieren und Prozesse zu automatisieren – direkt im Browser und eng verzahnt mit Lakehouse, Warehouse und Pipelines.

Interne Projektdokumente zeigen, dass Notebooks insbesondere bei Datenbereinigung, API‑Automatisierungen, Multi‑Thread‑Abfragen und Machine‑Learning‑Szenarien eingesetzt werden.

Auch für Business Central APIs bestehen Abhängigkeiten rund um Outbound‑Zugriffe und Authentifizierung, was in deinen BC‑Anforderungsdokumenten detailliert beschrieben ist.

Was ist ein Notebook in Microsoft Fabric?

Ein Notebook ist ein interaktives Dokument, das Code‑Zellen (Python, SQL oder Spark/PySpark), Text‑Zellen und Visualisierungen kombiniert.

In Fabric laufen Notebooks in einer Spark‑basierten Compute‑Engine, ergänzt durch Pandas‑Unterstützung für kleinere Datenmengen. Dies wird in deiner internen Test‑Dokumentation bestätigt.

Typische Einsatzbereiche:

- Datenbereinigung (z. B. Entfernen fehlerhafter NAV-Daten)

- Transformation großer Datenmengen (z. B. Ledger‑Entries aus Business Central)

- API‑Abfragen & Automatisierungen (z. B. REST POST Prozesse)

- Data‑Science: ML‑Modelle trainieren, testen, deployen (Fabric ruft Modelle im Notebook auf und operationalisiert sie).

Wie funktionieren Notebooks technisch?

1. Spark‑Cluster startet automatisch

Sobald das Notebook ausgeführt wird, initialisiert Fabric einen Spark‑Compute‑Cluster.

Vorteile laut interner Dokumentation:

- extrem schnelle parallele Verarbeitung

- Aufteilung großer Tabellen in Partitionen

- ideal für große NAV/BC‑Datenmengen, z. B. Buchungsdaten

2. Zugriff auf Lakehouse & Warehouse

Notebooks arbeiten direkt mit Lakehouse‑Delta‑Tabellen, können aber auch:

- CSV‑Dateien aus NAV‑Exporten lesen

- JSON‑Dateien verarbeiten

- SQL‑Warehouse für Abfragen nutzen

- Views erstellen oder aktualisieren

3. Mix aus Spark & Pandas

- PySpark für große BC‑Datenlast

- Pandas für kleinere NAV‑Dateien (z. B. Artikelstammdaten)

Interne Notizen empfehlen ausdrücklich, Pandas für kleinere Dateien zu nutzen, weil die Datentypen automatisch besser erkannt werden.

4. Einbindung in Pipelines

Notebooks lassen sich nahtlos durch Pipelines ausführen.

Im BC‑Datenfluss kann z. B. erfolgen:

- Pipeline lädt Daten → Notebook transformiert Daten → Gold‑Schicht aktualisiert

- ML‑Workflow: Pipeline lädt Rohdaten → Notebook führt Scoring durch → Ergebnisse landen im Lakehouse.

5. API‑Automatisierung

In internen Teams‑Unterhaltungen wird beschrieben, wie Notebooks REST‑APIs aufrufen, z. B.:

- Synchronisation zwischen CI‑Journey und Fabric

- Business Central API‑Aufrufe über App‑Registrierungen und Outbound Access Protection Einstellungen

Notebooks sind eines der leistungsfähigsten Werkzeuge in Microsoft Fabric.

Sie kombinieren Code, Analyse und Automatisierung in einer einzigen, flexiblen Umgebung.

- flexible API‑Anbindungen

- schnelle und skalierbare Transformation

- Migration historischer NAV‑Daten

- Aufbau moderner Datenarchitekturen

- Umsetzung von Machine‑Learning‑Use‑Cases.

Damit sind Notebooks ein unverzichtbares Werkzeug in jeder modernen Fabric‑Datenplattform.

Haben Sie noch Fragen oder möchten Sie mehr über unsere Methoden erfahren? Kontaktieren Sie uns – wir zeigen Ihnen, wie Sie Ihre Daten für nachhaltigen Erfolg nutzen können.